Нейросети представляют собой мощные инструменты, которые находят широкое применение во многих областях. Однако, вместе с их преимуществами, нейросети также подвержены уязвимостям и атакам, которые требуют особого внимания и разработки соответствующих методов защиты.

Примеры атак

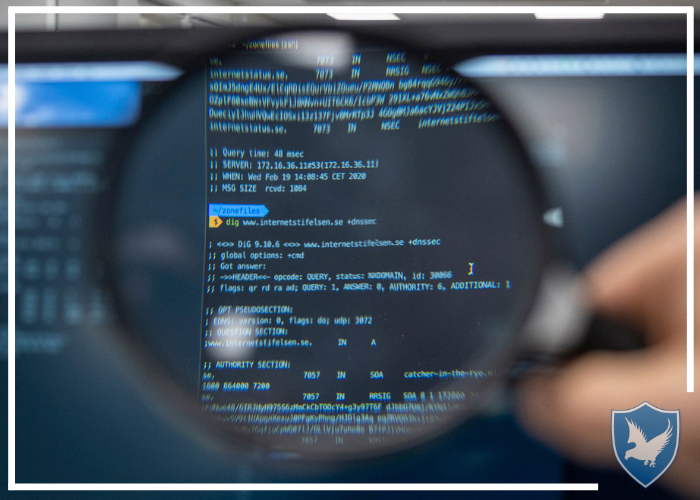

Распространенной уязвимостью является атака с помощью малоизученных примеров, или атака с измененными примерами (adversarial attacks). В этой атаке, небольшие изменения входных данных, такие как изображения, могут привести к неправильным выводам нейросети. Например, добавление незаметного шума к изображению может привести к тому, что нейросеть неправильно идентифицирует объект на изображении. Такие атаки могут быть использованы для обмана системы безопасности, автоматического распознавания или автономных автомобилей.

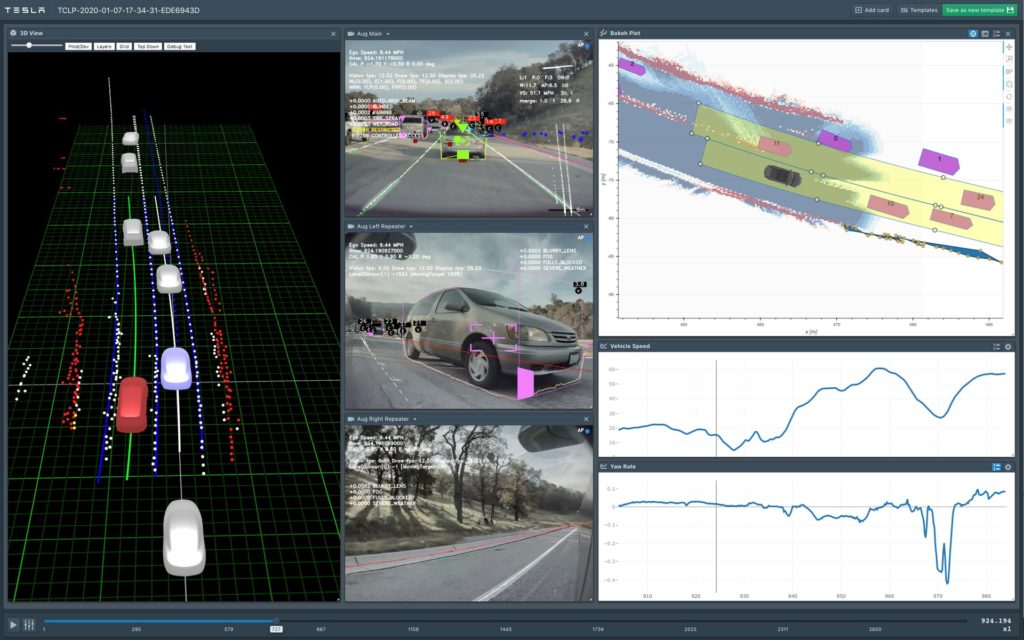

Другой известный пример — внедрение вредоносного кода (backdoor attacks). В этом случае, злоумышленники могут модифицировать нейросеть путем внедрения вредоносного кода в ее модель или обучающие данные. Когда такая нейросеть используется в реальных условиях, вредоносный код может быть активирован и приведет к неправильным или опасным действиям. Нейросеть, которая отвечает за автономное вождение автомобиля, может «забывать» команды и ограничения, что приведет беспилотный автомобиль к ДТП.

Методы защиты

Для защиты нейросетей от таких атак, исследователи разрабатывают различные методы и подходы. Один из подходов — аугментация данных. Этот метод заключается в обучении нейросети на различных вариантах одного и того же объекта, что помогает повысить ее устойчивость к атакам с измененными примерами. Другой метод — использование алгоритмов проверки достоверности данных, которые позволяют обнаруживать и отфильтровывать подозрительные или вредоносные входные данные. Также ведутся исследования в области устойчивого обучения, где нейросети обучаются с учетом возможных атак и способности противостоять им.

Этические аспекты использования нейросетей также становятся все более важными. Вопросы прозрачности, ответственности и конфиденциальности данных — неотъемлемая часть разработки и использования нейросетей. Регуляторы и организации также стремятся разработать нормативные акты и стандарты, которые обеспечат этичное и безопасное использование искусственного интеллекта.

Безопасность нейросетей — это сложная и комплексная проблема. Уязвимости и атаки на нейросети требуют постоянного внимания и новых методов защиты. Исследования в этой области продолжаются, и разработчики нейросетей стремятся создать надежные и безопасные системы для использования в широком спектре приложений.